Récemment, une image a commencé à circuler sur le web, montrant le pape François portant une doudoune blanche ultra-tendance. En quelques heures, elle est devenue virale, les internautes à la fois surpris et impressionnés du sens du style du souverain pontife, âgé de 86 ans. Il s’est finalement avéré que l’image avait été entièrement générée par l’intelligence artificielle.

Bien que cet exemple soit relativement inoffensif, il est fort à parier que les prochains ne le soient pas autant. La possibilité de créer des images synthétiques convaincantes de dirigeants politiques, de célébrités, voire de personnes que vous connaissez, en l’espace de quelques secondes, est à portée de main. Aujourd’hui, la puissance de l’IA s’étend notamment aux outils de génération audio, permettant de créer des clips réalistes de n’importe qui, disant n’importe quoi, simplement en téléchargeant un échantillon de sa voix. Quel que soit le type de contenu, notre incapacité à faire la différence entre la réalité et la fiction est en passe de devenir une réalité.

Voir, c’est croire : ici réside le danger principal des médias synthétiques. Alors que nous faisons généralement preuve de prudence à l’égard des écrits à la source inconnue ou peu fiable, nous avons tendance à croire que ce que nous voyons et entendons est bien « réel ». 50% du cerveau est consacré au traitement visuel, ce qui fait que nous concentrons naturellement notre attention sur des contenus tels que les images. Une étude du Massachusetts Institute of Technology a montré que notre cerveau peut traiter une image en seulement 13 millisecondes ; cela ne laisse pas beaucoup de temps à la réflexion.

Mais nous pouvons tirer parti de notre nature : « voir, c’est croire » est exactement ce dont nous avons besoin pour lutter contre les dangers de la désinformation à grande échelle. La bonne solution permettra aux créateurs de contenu qui veulent être dignes de confiance de montrer leur travail afin que nous puissions croire ce qui est réel.

Montrez votre travail, rétablissez la confiance

Cette approche est à la base de la Content Authenticity Initiative (CAI), dont la coalition mondiale s’est élargie à plus de 1 000 membres issus de tous les domaines de la technologie, des médias et de la politique depuis sa création en 2019. Ce soutien massif en seulement quatre ans démontre le besoin urgent d’une solution mondiale à la désinformation.

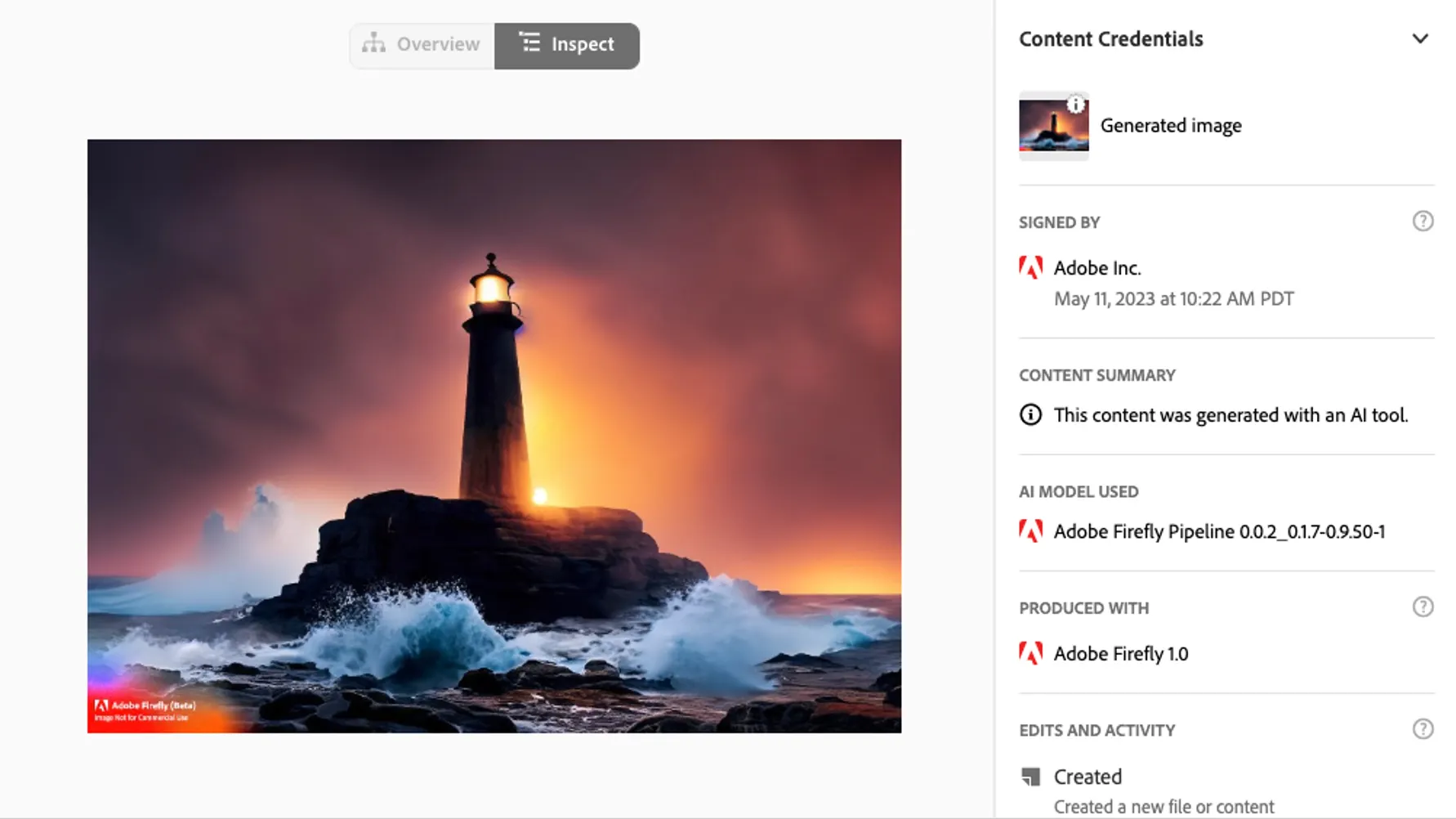

La CAI apporte de la transparence au contenu numérique par le biais de métadonnées (les Content Credentials) accompagnant chaque image. Il s’agit essentiellement d’une étiquette nutritionnelle pour les images, qui vous indiquent ce que vous consommez, au moment où vous le consommez. Ils peuvent contenir des informations telles que le nom, la date et les outils utilisés pour créer une image, ainsi que toutes les modifications appliquées. Ainsi, lorsque vous voyez le contenu, vous pouvez voir par vous-même comment il a été créé. En fournissant des informations directement au public, cette initiative permet aux consommateurs de se forger leur propre opinion quant à qui -et quoi- croire.

Les Content Credentials peuvent également indiquer si une image a été générée par l’IA. Dans le modèle d’IA générative Firefly d’Adobe, cette information est automatiquement affichée. Récemment, d’autres développeurs d’IA générative, dont Stability AI et Spawning AI, ont accepté cette approche et rejoint la CAI, permettant ainsi d’apporter plus de transparence à tous les types de contenus numériques, qu’ils soient créés par un être humain ou par l’IA.

Les Content Credentials de cette image indiquent qu’elle a été générée via Adobe Firefly.

Plus important encore, la technologie des Content Credentials est gratuite et open source. Chacun peut ainsi l’intégrer dans ses propres produits et plateformes, sur la base d’une norme ouverte créée par la Coalition for Content Provenance and Authenticity (C2PA). Les récentes mises en œuvre de la norme C2PA démontrent le potentiel de cette technologie.

Par exemple, le photojournaliste Ron Haviv a travaillé avec Starling Labs pour ajouter des Content Credentials à ses images. Les photographies, présentées dans le magazine Rolling Stone, sont désormais accompagnées d’un contexte vérifié : les lecteurs peuvent ainsi facilement comprendre qu’elles ont été capturées lors de la guerre de Bosnie de 1992, et non de la guerre en cours en Ukraine, comme cela avait été prétendu à tort. Leica et Nikon, deux des leaders du marché de l’appareil photo, intègrent également la norme C2PA directement dans les appareils photo pour documenter les informations essentielles, telles que le nom, la date, le modèle et le fabricant de l’appareil photo, et même le contenu de l’image, afin de favoriser la transparence et l’authenticité dès le moment où une image est capturée.

Mais pour que cette solution fonctionne, tout le monde doit l’adopter. Nous avons besoin des Content Credentials là où nous capturons, créons et distribuons du contenu. Bien que la CAI compte déjà plus de 1 000 membres, il reste encore beaucoup à faire.

Implémenter les Content Credentials pour protéger l’intégrité des élections

La désinformation est souvent utilisée pour dépeindre des événements ou des personnes d’une certaine façon pour un gain politique. Même sans mauvaise intention, les images truquées peuvent amener les électeurs à se forger une opinion politique sur la base d’inexactitudes ou de contre-vérités. À l’approche des élections présidentielles américaines de 2024, nous ne pouvons que nous attendre à ce que ce problème prenne de l’ampleur. Nous risquons de voir les gens perdre confiance dans les faits et peut-être même dans le processus électoral. La première fois que les gens verront des informations erronées, ils se sentiront dupés. La deuxième fois, ils ne croiront plus rien de ce qu’ils verront ou entendront, même s’il s’agit de la vérité. À ce stade, c’est toute notre démocratie qui est en danger si personne ne dispose d’un moyen fiable d’obtenir des faits.

L’innovation responsable, un engagement collectif

La désinformation n’est pas un phénomène nouveau, mais le potentiel d’utilisation abusive de l’IA a aggravé le problème. Il est désormais urgent d’y trouver une solution. La bonne nouvelle, c’est que nous disposons déjà d’une solution opérationnelle qui, grâce à la collaboration des secteurs privés et publics, peut faire une réelle différence dans la lutte contre la désinformation. Immédiatement.

C’est maintenant à nous de jouer : tous les acteurs, qu’il s’agisse d’entreprises de la tech, de fabricants d’appareils photo, d’organes de presse ou de plateformes de médias sociaux, doivent mettre en œuvre cette nouvelle technologie. Les gouvernements doivent s’efforcer de mettre en place des normes de transparence dans tous les secteurs et d’informer le public des dangers de la désinformation et des outils dont nous disposons pour la combattre. Nous devrions tous exiger ce niveau de transparence de notre contenu numérique. Nous avons une solution : si nous n’agissons pas, nous faisons partie du problème.

Lorsqu’on entend parler d’innovation responsable, voici ce dont il s’agit. C’est ainsi que nous réaliserons l’incroyable puissance de l’IA tout en prenant les mesures nécessaires pour éviter qu’elle ne tombe entre les mains des mauvaises personnes. La démocratie est en jeu et nous avons tous un rôle à jouer pour la protéger.